图灵小伙伴 | 「北极雄芯」创始人马恺声应邀出席2024玄武湖大模型产业分享会

2024-04-10

智能涌现,生成无限,为推动AI大模型创新发展,构建高效协同的产业创新生态,4月9日,玄武湖大模型产业分享会活动成功举办。会议邀请行业领域知名专家、学者、企业家共话大模型产业的创新未来,共同探讨大模型时代下数实融合的新业态、新模式、新路径,清华大学交叉信息研究院助理教授、北极雄芯创始人马恺声教授应邀出席并发言。

活动下半场,马恺声教授与深算院副院长蔡晟,清微智能执行总裁邱召强,南京电信副总裁汪平,无问芯穹副总裁李枫等专家及企业家们,探讨大模型算力与供应链的未来,清华大学交叉信息研究院副教授徐葳主持。马恺声教授重点介绍了北极雄芯的大模型方案及相关产品规划。

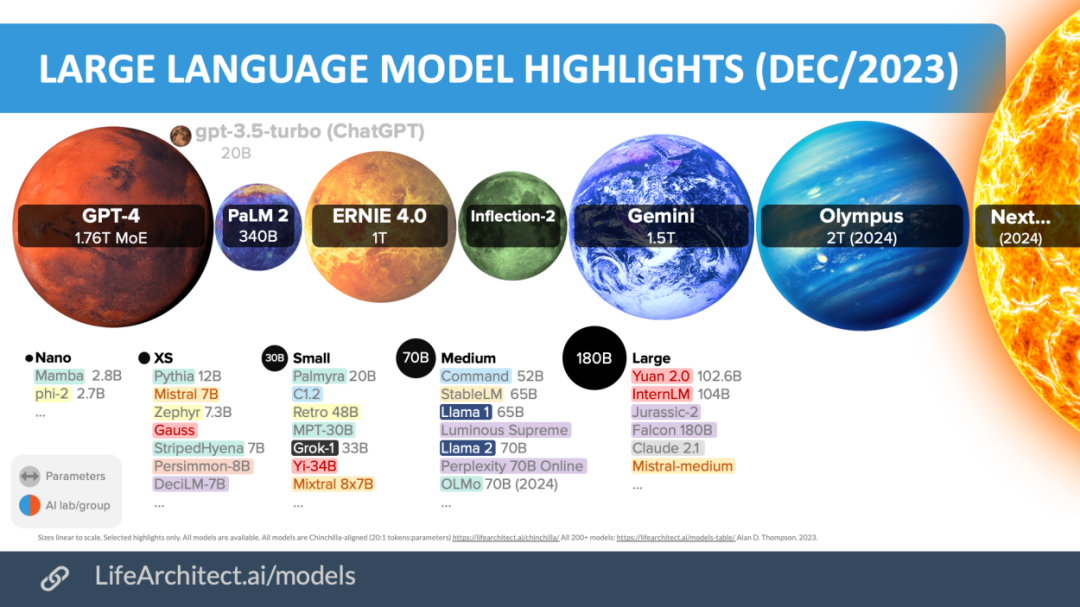

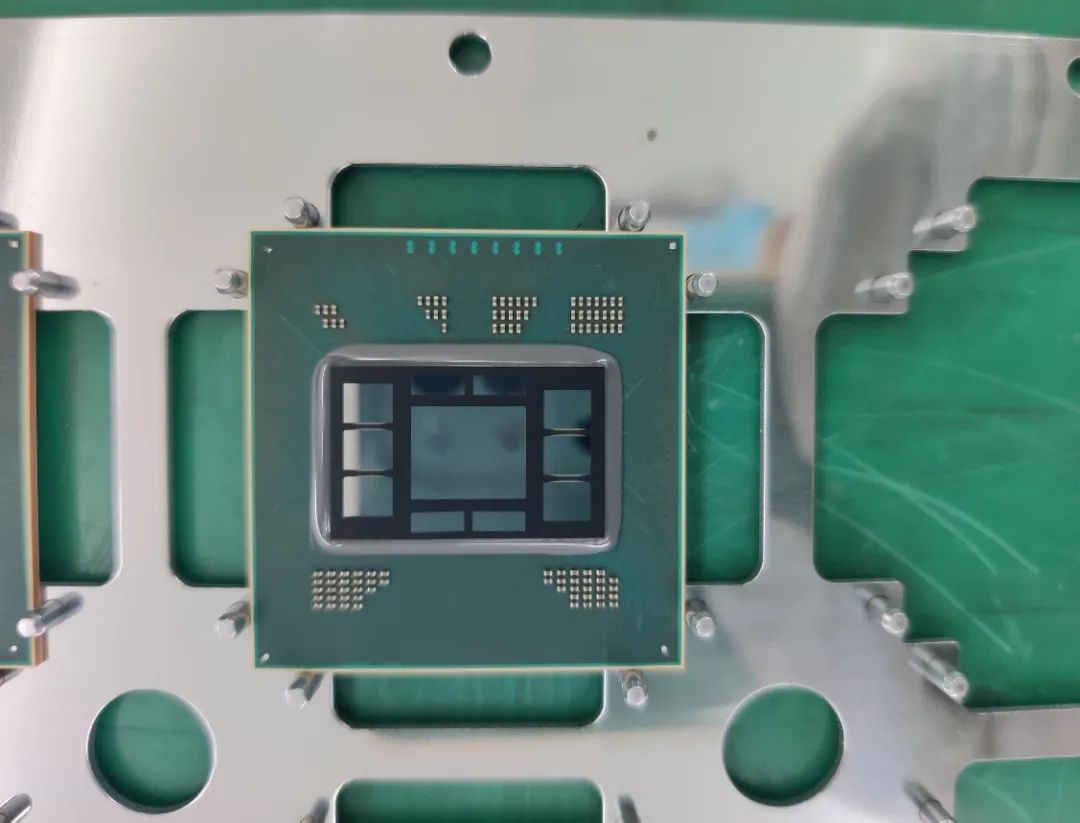

自ChatGPT面世以来,引领了大模型时代的变革,大模型遍地开花。容量、算力、带宽是驱动大模型发展的三驾马车,如何寻求三者之间的有效平衡并且成本可控成为行业亟需解决的难题。因此,规模化低成本部署将是大模型进一步发展的刚需。后摩尔时代,先进制程工艺芯片面临初始投入巨大,芯片面积增大,制造良率大幅下滑等痛点,Chiplet成为进一步提升芯片性能的有效路径。

Chiplet架构有助于大模型大幅降低推理成本,并提升算力实际利用率。在降低算力构建成本方面,Chiplet架构可突破单芯片面积上限,提升单卡计算性能、内存带宽;提升生产良率,降低量产成本;有效缓解先进工艺受限风险。在提升实际有效算力方面,可有效提升ASIC算力利用率;计算模块可独立迭代,周期短、投入成本低;支持不同场景计算模块灵活拼接;存储/带宽可灵活扩展。

作为国内领先的Chiplet集成商,北极雄芯自研推出Chiplet方案,确保大模型推理方案供应链可控、成本低。公司自研的NPU支持主流AI模型/算子,可提高并行利用率、调度利用率、缓存利用率,算法优化空间等,降低带宽压力,并配备全套工具链及协助部署。

对话最后,马恺声教授介绍了公司大模型推理产品规划。2024年,北极雄芯将推出基础芯粒以及推理加速卡等产品。